Git

Configuring Git

git config --global user.name "spider_net" # username init, seen in commits

git config --global user.email "test@gmail.com" # Init of user e-mail

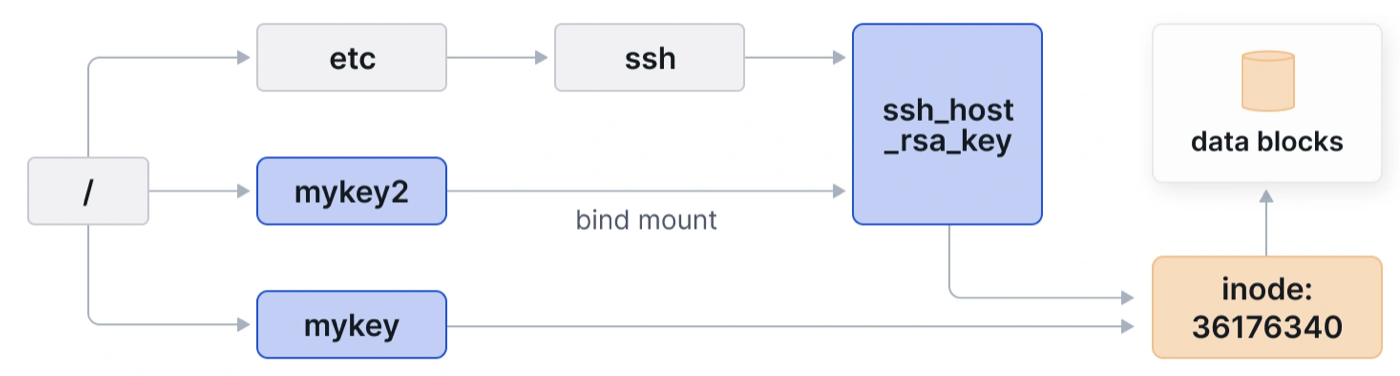

SSH одновременно с GitHub и Gitlab

Для работы с одной системы с тем и другим репозиторием по SSH нужно создать ключи SSH под оба, а также прописать в файле конфигурации профили подключения:

Host github.com

IdentityFile ~/.ssh/id_rsa

IdentitiesOnly yes

Host gitlab.com

IdentityFile ~/.ssh/id_ecdsa

Для проверки работоспособности конфигурации можно подключиться с помощью ssh напрямую:

Для избежания ошибок следует:

- В имени ключа не использовать знак тире

-

- Сначала клонировать удалённый репозиторий с помощью

git clone, далее локально его обновить и синхронизировать с помощью git push origin main

Cloning Repository

git clone https://github.com/drupal/drupal.git drupal7

Initialising Local & Remote Repo

git init # local repo init

git status # check status

git branch -m master main # change master branch to main, for GitLab

git add * # add all files to repo, .gitignore file lets you hide junk files, password files from syncing

git commit -m "Hello world"

git config --global user.email "Ivan@example.com"

git config --global user.name "Ivan the Terrible"

git log

git remote add origin git@gitlab.com:<name of account>/<project name>.git

git push origin main

Cloning Remote Repo on Amazon

Certificate file needed in .ssh folder. Also a config file .ssh/config is needed:

Host git-codecommit.us-east-1.amazonaws.com

User Your-SSH-Key-ID, such as APKAEIBAERJR2EXAMPLE

IdentityFile Your-Private-Key-File, such as ~/.ssh/codecommit_rsa or ~/.ssh/id_rsa

Git commands to clone repo:

git clone ssh://<SSHKEY-ID>@git-codecommit.<REGION>.amazonaws.com/v1/repos/<REPO-NAME>

# Example:

git clone ssh://ABCDOIJKHJGYTHJG7@git-codecommit.eu-central-1.amazonaws.com/v1/repos/myrepo

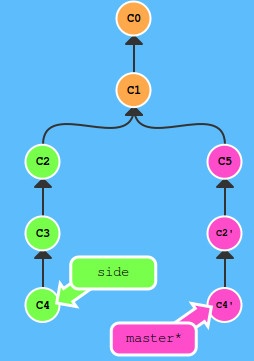

Branching

Create new branch: git branch new-branch

Pointer does not automatically switch to new branch, it is left on main branch, so you need to switch manually: git checkout new-branch

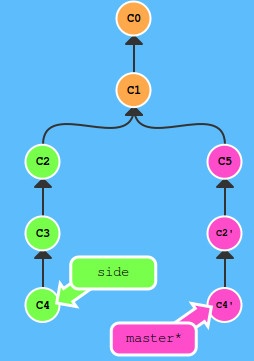

Merging Branches

- Switch to branch for merging

- Merge

- Check pointers point to one place OR merge the other branch with the current one

git commit

git checkout main

git commit

git merge new-branch

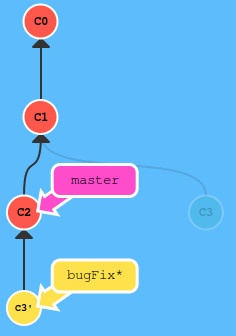

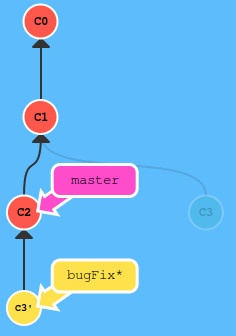

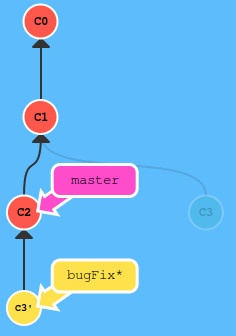

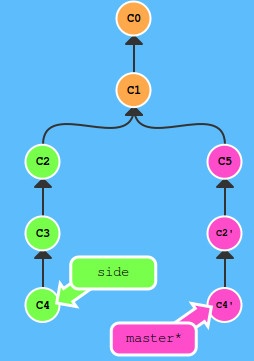

Change of branches to make it look as if the functionality was developed step-by-step, not in parallel.

git rebase master

git checkout master

git rebase bugFix

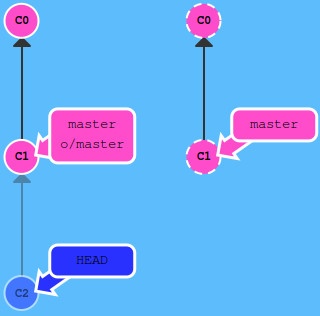

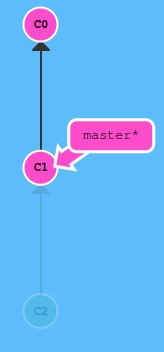

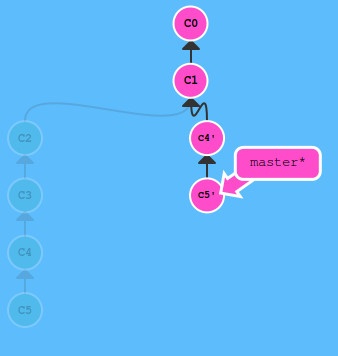

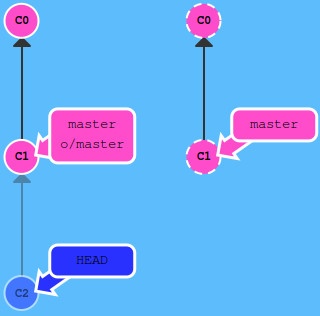

Pointer

HEAD is the pointer to current project state. By default HEAD points to current branch.

You can go back by commits or by direct commit hash:

git checkout C1

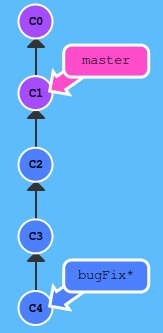

You can use syntax “^K” for going up 1 level (where K is the route number to choose if there are more than 1 parent. By default, K=1) and “~N” for N steps up:

git checkout master^

# OR

git checkout bugFix^^

# OR

git checkout bugFix~2

# same route on schema from picture

# or build a sequence

git checkout bugFix^~1

Chaning main branch to several commits backwards:

git branch -f master HEAD~3

# -f means force - direct remap of branch for commit

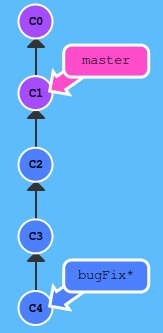

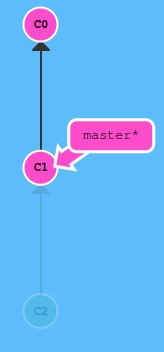

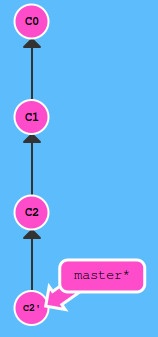

Undo Actions

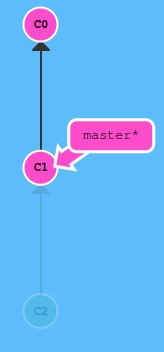

For 1-person local repo do reset.

For multi-person remote repo, do revert.

git reset HEAD~1

# OR

git revert HEAD

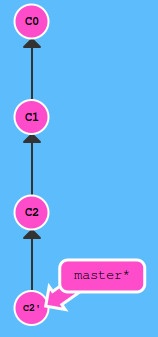

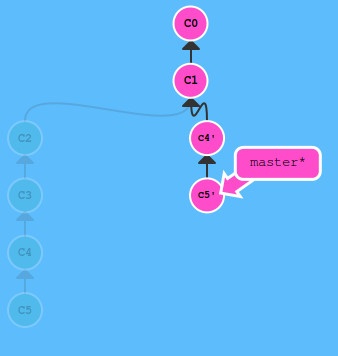

In c2’ state are the changes, which cancel state C2

In c2’ state are the changes, which cancel state C2

Moving commits

Chosen commits are moved upon current commit using cherry-pick command. Used when it is known what specific commits to move: git cherry-pick C2 C4

git rebase -i HEAD~4 --aboveAll

Small commit modifications

You can modify a commit, dividing it into two with same parent:

git commit --amend

Tagging commits

Marking milestones is done with tags. They block the commit from changes, moving etc.:

git tag v1 <hash> # if hash is not provided, then current commit is tagged

Tags serve as anchors in tree of commits. To define your position against the nearest anchor, use command:

git describe <ref> # if <ref> is not provided, current commit will be described

Naming

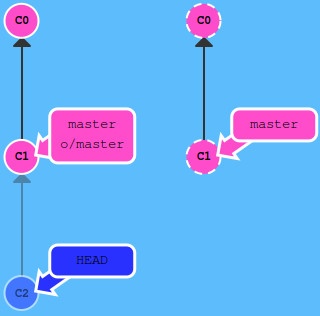

Remote branches have a naming convention: <remote name>/<branch name>

Main remote i called origin. So master branch is origin/main. When doing commit in local branch, the system is put into detached HEAD mode:

git checkout origin/master

git commit

Fetch data from remote repository

When data is downloaded from remote repo, the origin/main branch is updated to reflect the new commits:

git fetch

Only commits non-present locally are downloaded. No local state of files is changed after download. The local main status is unchanged. To change, a merge must be done:

git fetch + git merge = git pull

git pull

Publishing local repository to remote

Publishing syncs commits at remote repo and local repo (main and origin/main point to the same commit):

git push

If the remote repo has changed by someone by the time you need to push there, it means that your feature is based on an old commit. So Git will not let you push. Before push, a fetch must be made to sync the changes, than a rebase or merge to update the main branch, and then a push:

git fetch + git rebase origin/main + git push OR git fetch + git merge origin/main + git push = git pull –rebase

git pull --rebase

Changing main and origin/main

You can change that another branch will be main for the remote repo:

`git checkout -b side origin/main

Push arguments

You can specify what branch to push:

git push origin main

origin = remote repo,

main = branch to take commit from.

It does not matter where the HEAD is at this moment. You can specify where to push commits using git push origin <source>:<destination> notation:

git push origin side^2:master

If push is made to a non-existent branch on remote repo, Git will create this branch:

git push origin main:newBranch

Fetch arguments

Same as push, but the other wat around. Go to foo branch on remote repo, download commits from there to local branch origin/foo:

git fetch origin foo

Subsections of Rust

Libraries

Articles in Section

Одноразовые библиотеки

Если библиотека нужна лишь в 1 функции, можно в ней объявить её использование.

pub fn hash_password(password: &str) -> String {

use sha2::Digest;

// ... тело функции ...

}

Library Unit-tests

Примеры:

pub fn greet_user(name: &str) -> String {

format!("Hello {name}")

}

pub fn login(username: &str, password: &str) -> bool {

username == "admin" && password == "P@ssw0rd"

}

#[cfg(test)]

mod tests {

use super::*;

#[test]

fn test_greet_user() {

assert_eq!("Hello Alex", greet_user("Alex"));

}

#[test]

fn test_login() {

assert!(login("admin", "P@ssw0rd"));

}

}

Запуск тестов - командой cargo test

Subsections of Libraries

Anyhow Error Handler

Библиотека работы с ошибками - https://docs.rs/anyhow/latest/anyhow/

- Использует единый тип Error для всех ошибок;

- Добавляет контекст к ошибкам;

- Поддержка backtrace для debug;

Установка

Использование

Anyhow создаёт алиас наподобие Result<T> = Result<T, Box<dyn Error>>, чтобы скрыть тип ошибок и сделать его универсальным.

// ---- Без Anyhow

fn string_error() -> Result<(), String> {

Ok(())

}

fn io_error() -> Result<(), std::io::Error> {

Ok(())

}

fn any_error() -> Result<(), Box<dyn Error>> {

string_error()?;

io_error()?;

Ok(())

}

// ---- С Anyhow:

use anyhow::Result;

fn string_error() -> Result<()> {

Ok(())

}

fn io_error() -> Result<()> {

Ok(())

}

fn any_error() -> Result<()> {

string_error()?;

io_error()?;

Ok(())

}

Пример неудачного чтения файла:

use anyhow::{Context, Result};

fn read_config_file(path: &str) -> Result<String> {

std::fs::read_to_string(path).with_context(|| format!("Failed to read file {}", path))

}

fn main() -> Result<()> {

let config_content = read_config_file("conf.txt")?;

println!("Config content:\n{:?}", config_content);

Ok(())

}

Result<T> становится алиасом к Result<T, anyhow::Error>;Context, with_context() позволяет добавить подробности к ошибке, в случае неуспеха функции чтения read_to_string();- Оператор

? выносит ошибку вверх, при этом авто-конвертирует её тип в anyhow::Error.

Замена Box<dyn> с контекстом

Возьмём пример, в котором чтение файла std::fs::read_to_string() (может быть неудачным), далее дешифровка его контента с помощью base64 decode() (может не получиться) в цепочку байт, из которой формируется строка String::from_utf8() (может не получиться). Все эти три потенциальных ошибки имеют разный тип.

Один способ все три их принять на одну функцию, это с помощью Box<dyn std::error::Error>>, потому что все 3 ошибки применяют std::error::Error.

use base64::{self, engine, Engine};

fn decode() -> Result<(), Box<dyn std::error::Error>> {

let input = std::fs::read_to_string("input")?;

for line in input.lines() {

let bytes = engine::general_purpose::STANDARD.decode(line)?;

println!("{}", String::from_utf8(bytes)?);

}

Ok(())

}

Подход рабочий, но при срабатывании одной из трёх ошибок, судить о происхождении проблемы можно будет лишь по сообщению внутри ошибки.

В случае применения Anyhow, можно заменить им Box<dyn>, при этом сразу добавить контекстные сообщения, которое поможет понять место:

use anyhow::Context;

use base64::{self, engine, Engine};

fn decode() -> Result<(), anyhow::Error> {

let input = std::fs::read_to_string("input")

.context("Failed to read file")?; // контекст 1

for line in input.lines() {

let bytes = engine::general_purpose::STANDARD

.decode(line)

.context("Failed to decode the input")?; // контекст 2

println!(

"{}",

String::from_utf8(bytes)

.context("Failed to cenvert bytes")? // контекст 3

);

}

Ok(())

clap CLI

Установка

Установить вместе с допом derive, чтобы добавлять clap как признак (trait) у структур данных.

Как использовать

Добавка clap позволяет парсить аргументы командной строки, а также добавляет ключи “-h” и “–help” для помощи без кода:

use clap::Parser;

#[derive(Parser, Debug)]

struct Args {

arg1: String,

arg2: usize,

}

fn main() {

let args = Args::parse();

println!("{:?}", args)

}

При запуске данная программа требует 2 аргумента, притом второй обязательно числом.

Добавление описаний

Имя программы и версия вносятся отдельным признаком. Доп. поля описания вносятся с помощью спец. комментариев ///:

use clap::Parser;

#[derive(Parser, Debug)]

#[command(author = "Author Name", version, about)]

/// A very simple CLI parser

struct Args {

/// Text argument option

arg1: String,

/// Number argument option

arg2: usize,

}

fn main() {

let args = Args::parse();

println!("{:?}", args)

}

Добавка флагов

Флаги добавляем с помощью аннотации #[arg(short, long)] для короткого и длинного именования флага. Если у 2-х флагов одинаковая первая буква, можно указать вручную их короткую версию. Короткая версия не может быть String, можно только 1 char.

<..>

struct Args {

#[arg(short = 'a', long)]

/// Text argument option

arg1: String,

#[arg(short = 'A', long)]

/// Number argument option

arg2: usize,

}

<..>

Необязательные флаги

Для отметки аргумента как необязательного достаточно указать его тип как Option<тип> и в скобках исходный тип данных:

struct Args {

#[arg(short = 'a', long)]

/// Text argument option

arg1: String,

#[arg(short = 'A', long)]

/// Number argument option

arg2: Option<usize>,

}

Такой подход потребует обработать ситуацию, когда в arg2 ничего нет. Вместо так делать, можно указать значение по умолчанию:

struct Args {

#[arg(short = 'a', long)]

/// Text argument option

arg1: String,

#[arg(default_value_t=usize::MAX, short = 'A', long)]

/// Number argument option

arg2: usize,

}

Теперь arg2 по умолчанию будет равен максимальному числу usize, если не указано иное.

Валидация введённых значений

В случае аргумента-строки есть возможность ввести пустую строку из пробелов " ". Для исключения таких вариантов, вводится функция валидации и её вызов:

use clap::Parser;

#[derive(Parser, Debug)]

#[command(author = "Author Name", version, about)]

/// A very simple CLI parser

struct Args {

#[arg(value_parser = validate_argument_name, short = 'a', long)]

/// Text argument option

arg1: String,

#[arg(default_value_t=usize::MAX, short = 'A', long)]

/// Number argument option

arg2: usize,

}

fn validate_argument_name(name: &str) -> Result<String, String> {

if name.trim().len() != name.len() {

Err(String::from(

"строка не должна начинаться или заканчиваться пробелами",

))

} else {

Ok(name.to_string())

}

}

fn main() {

let args = Args::parse();

println!("{:?}", args)

}

Теперь при попытке вызвать программу tiny-clapper -- -a " " будет показана ошибка валидации.

Command CLI

Библиотека позволяет запускать команды в ОС.

Варианты использования

spawn — runs the program and returns a value with detailsoutput — runs the program and returns the outputstatus — runs the program and returns the exit code

Использование

Output - просто и быстро

let output = Command::new("cat")

.arg("/etc/issue")

.output()

.with_context(|| "ls command failed")?;

println!("{}", output.status);

println!("{}", String::from_utf8_lossy(&output.stdout));

println!("{}", String::from_utf8_lossy(&output.stderr));

❗Ограничение - можно вызывать только существующие объекты, нельзя добавлять свой текст.

spawn - гибкий ввод

Самый гибкий вариант, позволяющий делать свой ввод, а не только существующие команды и файлы-папки, это через spawn:

let mut child = Command::new("cat") // команда

.stdin(Stdio::piped())

.stdout(Stdio::piped())

.spawn()?;

let stdin = child.stdin.as_mut()?;

stdin.write_all(b"Hello Rust!\n")?; // текст к команде, /n обязателен

let output = child.wait_with_output()?;

for i in output.stdout.iter() { // цикл на случай многострочного вывода

print!("{}", *i as char);

}

Ok(())

❗Ограничение - можно подавать на вход текст лишь тем командам, которые требуют сразу указать вводный текст. При этом ряд команд делают паузу перед потреблением текста на вход, с такими свой ввод работать не будет это относится и к фильтрации через pipe = | grep <...> и аналоги.

Pipe (nightly) - полный ввод (не проверенный способ)

https://doc.rust-lang.org/std/pipe/fn.pipe.html

Для использования нужен nightly вариант Rust

rustup install nightly

rustup default nightly

Использование:

#![feature(anonymous_pipe)] // только в Rust Nightly

use std::pipe

let text = "| grep file".as_bytes();

// Запускаем саму команду

let child = Command::new("ls")

.arg("/Users/test")

.stdin({

// Нельзя отправить просто строку в команду

// Нужно создать файловый дескриптор (как в обычном stdin "pipe")

// Поэтому создаём пару pipes тут

let (reader, mut writer) = std::pipe::pipe().unwrap();

// Пишем строку в одну pipe

writer.write_all(text).unwrap();

// далее превращаем вторую для передачи в команду сразу при spawn.

Stdio::from(reader)

})

.spawn()?;

External link: https://docs.rs/itertools/latest/itertools/

Библиотека работы с итераторами

Sorting() a string of letters (with rev() - reverse order)

use itertools::Itertools;

let text = "Hello world";

let text_sorted = text.chars().sorted().rev().collect::<String>();

// rev() - Iterate the iterable in reverse

println!("Text: {}, Sorted Text: {}", text, text_sorted);

// Text: Hello world, Sorted Text: wroollledH

Counts() подсчёт количества одинаковых элементов в Array

use itertools::Itertools;

let number_list = [1,12,3,1,5,2,7,8,7,8,2,3,12,7,7];

let mode = number_list.iter().counts(); // Itertools::counts()

// возвращает HashmapHashMap<char, usize>,

// где ключи взяты из массива, значения - частота

for (key, value) in &mode {

println!("Число {key} встречается {value} раз");

}

По сути counts() создаёт HashMap, заменяя собой конструкцию или конструкцию на базе fold():

let mut number_count: HashMap<u32, u32> = HashMap::new();

for c in number_list {

*number_count.entry(c).or_insert(0) += 1;

}

Duplicates_by()

Можно получить итератор с повторяющимися элементами:

println!("{:?}",number_list.iter().duplicates_by(|x| *x)

.collect::<Vec<&u32>>()

// [2, 3, 6]

Тогда подсчёт количества одинаковых элементов:

println!("{:?}", number_list.iter().duplicates_by(|x| *x).count());

rand

Generating random numbers

External links:

Using rand lib example:

use rand::Rng;

fn main() {

let secret_of_type = rand::rng().random::<u32>();

let secret = rand::rng().random_range(1..=100);

println!("Random nuber of type u32: {secret_of_type}");

println!("Random nuber from 1 to 100: {}", secret); }

В старой версии библиотеки применялся признак gen(), который переименовали в связи с добавлением gen() в Rust 2024.

regex

Внешние ссылки:

Установка

REGEX Выражения

Один символ

. any character except new line (includes new line with s flag)

\d digit (\p{Nd})

\D not digit

\pX Unicode character class identified by a one-letter name

\p{Greek} Unicode character class (general category or script)

\PX Negated Unicode character class identified by a one-letter name

\P{Greek} negated Unicode character class (general category or script)

Классы символов

[xyz] A character class matching either x, y or z (union).

[^xyz] A character class matching any character except x, y and z.

[a-z] A character class matching any character in range a-z.

[[:alpha:]] ASCII character class ([A-Za-z])

[[:^alpha:]] Negated ASCII character class ([^A-Za-z])

[x[^xyz]] Nested/grouping character class (matching any character except y and z)

[a-y&&xyz] Intersection (matching x or y)

[0-9&&[^4]] Subtraction using intersection and negation (matching 0-9 except 4)

[0-9--4] Direct subtraction (matching 0-9 except 4)

[a-g~~b-h] Symmetric difference (matching `a` and `h` only)

[\[\]] Escaping in character classes (matching [ or ])

Совмещения символов

xy concatenation (x followed by y)

x|y alternation (x or y, prefer x)

Повторы символов

x* zero or more of x (greedy)

x+ one or more of x (greedy)

x? zero or one of x (greedy)

x*? zero or more of x (ungreedy/lazy)

x+? one or more of x (ungreedy/lazy)

x?? zero or one of x (ungreedy/lazy)

x{n,m} at least n x and at most m x (greedy)

x{n,} at least n x (greedy)

x{n} exactly n x

x{n,m}? at least n x and at most m x (ungreedy/lazy)

x{n,}? at least n x (ungreedy/lazy)

x{n}? exactly n x

Пустые символы

^ the beginning of text (or start-of-line with multi-line mode)

$ the end of text (or end-of-line with multi-line mode)

\A only the beginning of text (even with multi-line mode enabled)

\z only the end of text (even with multi-line mode enabled)

\b a Unicode word boundary (\w on one side and \W, \A, or \z on other)

\B not a Unicode word boundary

Группировка и флаги

(exp) numbered capture group (indexed by opening parenthesis)

(?P<name>exp) named (also numbered) capture group (names must be alpha-numeric)

(?<name>exp) named (also numbered) capture group (names must be alpha-numeric)

(?:exp) non-capturing group

(?flags) set flags within current group

(?flags:exp) set flags for exp (non-capturing)

Спец-символы

\* literal *, works for any punctuation character: \.+*?()|[]{}^$

\a bell (\x07)

\f form feed (\x0C)

\t horizontal tab

\n new line

\r carriage return

\v vertical tab (\x0B)

\123 octal character code (up to three digits) (when enabled)

\x7F hex character code (exactly two digits)

\x{10FFFF} any hex character code corresponding to a Unicode code point

\u007F hex character code (exactly four digits)

\u{7F} any hex character code corresponding to a Unicode code point

\U0000007F hex character code (exactly eight digits)

\U{7F} any hex character code corresponding to a Unicode code point

Типы символов по ASCII

[[:alnum:]] alphanumeric ([0-9A-Za-z])

[[:alpha:]] alphabetic ([A-Za-z])

[[:ascii:]] ASCII ([\x00-\x7F])

[[:blank:]] blank ([\t ])

[[:cntrl:]] control ([\x00-\x1F\x7F])

[[:digit:]] digits ([0-9])

[[:graph:]] graphical ([!-~])

[[:lower:]] lower case ([a-z])

[[:print:]] printable ([ -~])

[[:punct:]] punctuation ([!-/:-@\[-`{-~])

[[:space:]] whitespace ([\t\n\v\f\r ])

[[:upper:]] upper case ([A-Z])

[[:word:]] word characters ([0-9A-Za-z_])

[[:xdigit:]] hex digit ([0-9A-Fa-f])

Использование REGEX

Сверка с is_match()

use regex::Regex;

fn main() -> Result<(), Box<dyn std::error::Error>> {

let input = "hello, world!";

let pattern = Regex::new(r"hello, (world|universe)!")?;

let is_match = pattern.is_match(input);

println!("Is match: {}", is_match); // true

Ok(())

}

Для простого выяснения факта совпадения лучше всего пользоваться is_match как самым быстрым способом.

Поиск первого совпадения

let pattern = regex::Regex::new(r"hello, (world|universe)!")?;

let input = "hello, world!";

let first_match = pattern.find(input);

println!("First match: {}", first_match.unwrap().as_str());

Первое совпадение будет иметь тип Option<match>, а в случае отсутствия совпадений = None.

Поиск всех совпадений

let pattern = regex::Regex::new(r"hello, (world|universe)!")?;

let input = "hello, world! hello, universe!";

let matches: Vec<_> = pattern.find_iter(input).collect(); // find_iter()

matches.iter().for_each(|i| println!("{}", i.as_str()));

// matches = Vec<match> и содержит все совпадения

serde

Installing

Add serde framework with Derive feature to use it in structures and functions. Also add a separate serde_json lib for converting into specifically JSON:

cargo add serde -F derive

cargo add serde_json

Usage

Add serde, then mark the structures with Serialise, Deserialise traits and use serde_json for serialising:

use serde::{Deserialize, Serialize};

#[derive(PartialEq, Debug, Clone, Serialize, Deserialize)]

pub enum LoginRole {

Admin,

User,

}

#[derive(Debug, Clone, Serialize, Deserialize)]

pub struct User {

pub username: String,

pub password: String,

pub role: LoginRole,

}

pub fn get_default_users() -> HashMap<String, User> {

let mut users = HashMap::new();

users.insert(

"admin".to_string(),

User::new("admin", "password", LoginRole::Admin),

);

users.insert(

"bob".to_string(),

User::new("bob", "password", LoginRole::User),

);

users

}

pub fn get_users() -> HashMap<String, User> {

let users_path = Path::new("users.json");

if users_path.exists() {

// Load the file!

let users_json = std::fs::read_to_string(users_path).unwrap();

let users: HashMap<String, User> = serde_json::from_str(&users_json).unwrap();

users

} else {

// Create a file and return it

let users = get_default_users();

let users_json = serde_json::to_string(&users).unwrap();

std::fs::write(users_path, users_json).unwrap();

users

}

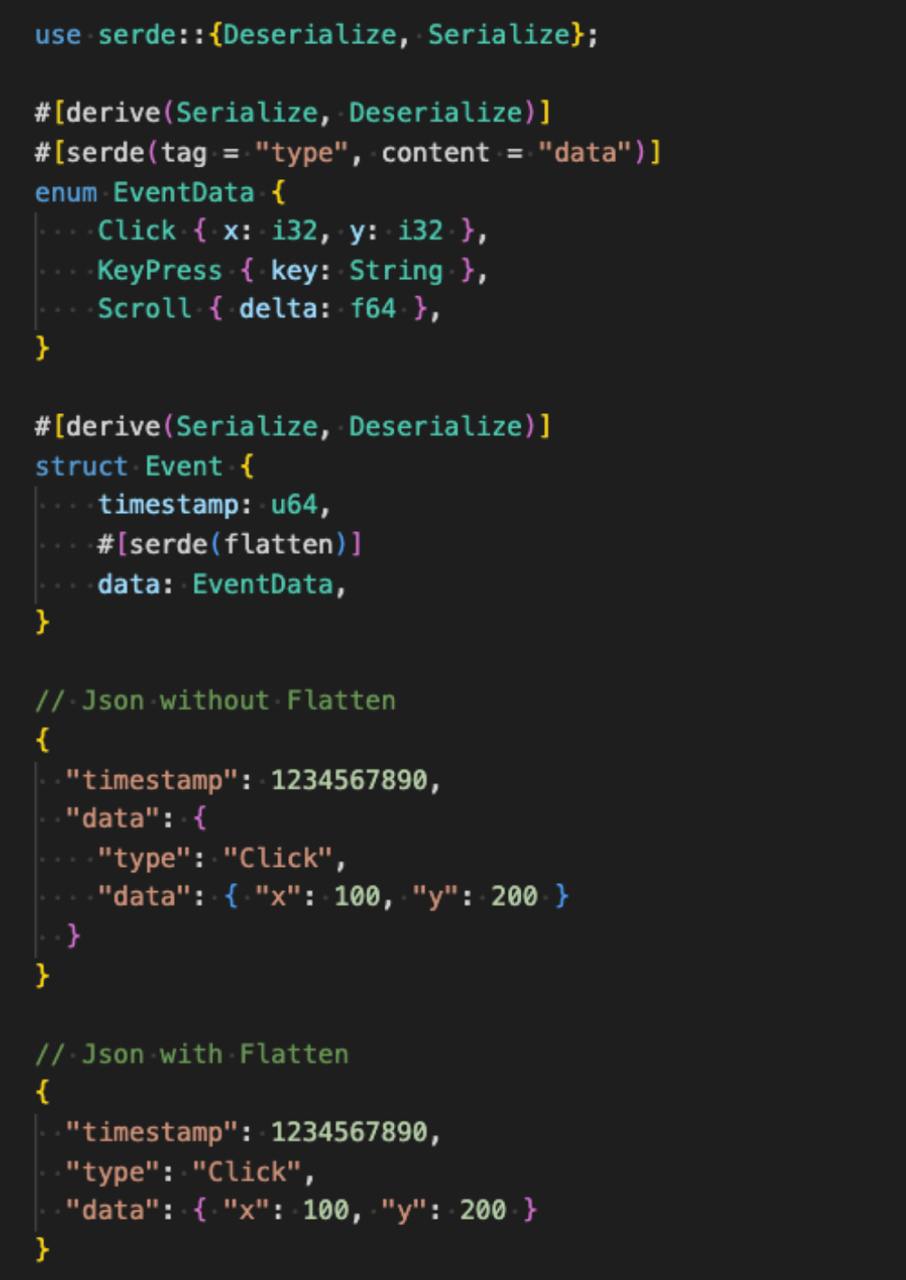

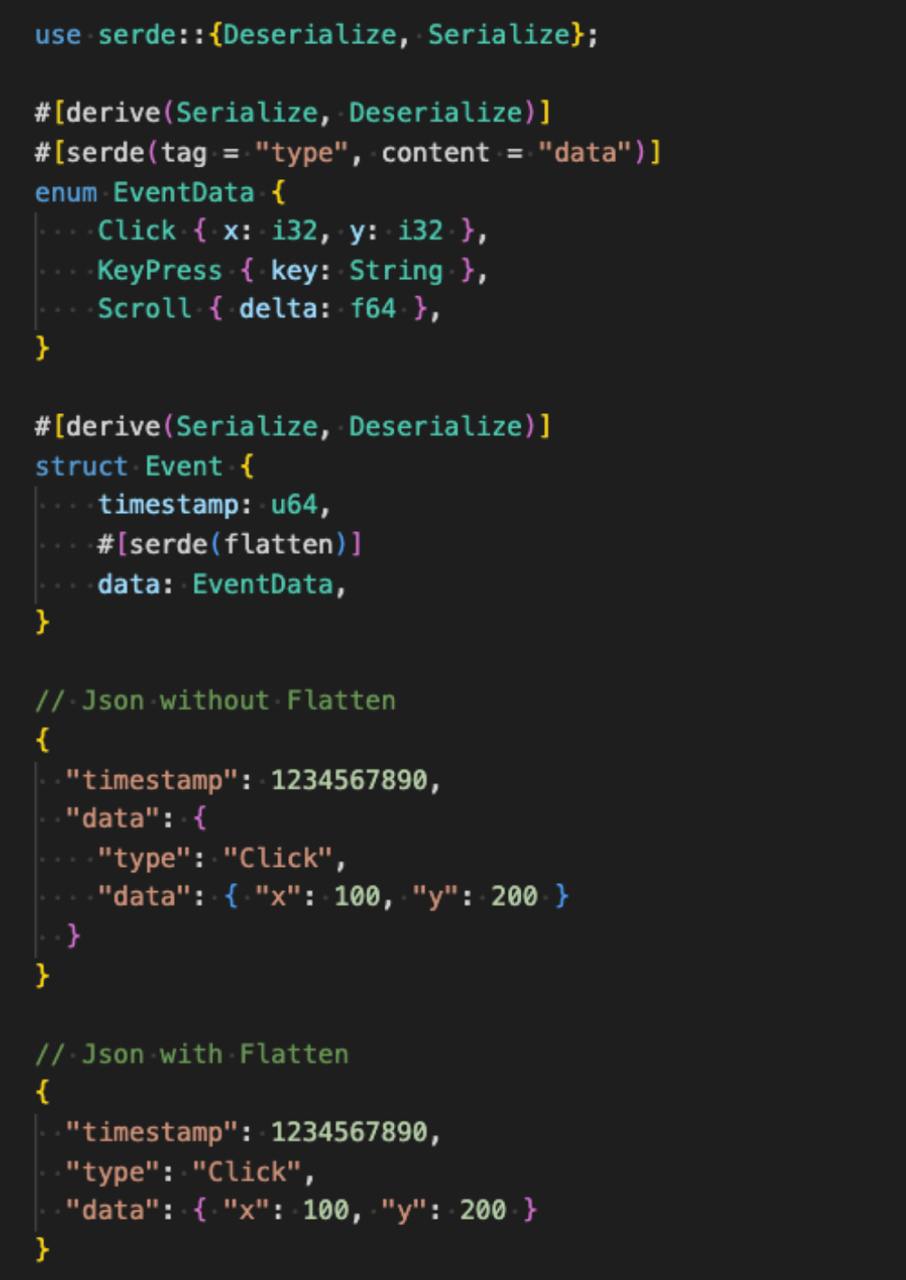

Flatten

Если при сериализации в JSON вы хотите, чтобы вложенные структуры или enum выглядели как часть общего объекта, используйте атрибут #[serde(flatten)]

Он убирает лишние уровни вложенности и делает JSON более читаемым и удобным:

sysinfo

Библиотека для изучения параметров системы и системных ресурсов.

https://docs.rs/sysinfo/latest/sysinfo/

Установка

Использование

use std::process; // номер процесса PID вывести

use sysinfo::{RefreshKind, System};

fn main() {

let _sys = System::new_with_specifics(RefreshKind::nothing());

let pid = process::id();

println!("System name: {:?}", System::name());

println!("System kernel version: {:?}", System::kernel_version());

println!("System OS version: {:?}", System::os_version());

println!("System host name: {:?}", System::host_name());

println!("Process ID: {}", pid);

}

С помощью RefreshKind::nothing() отключаются все динамические вещи, такие как остаток свободной памяти, загрузка ЦПУ, сеть и так далее, что драматически ускоряет опрос системы.

Можно частично опрашивать разные системные ресурсы, по заданным интервалам.

Tokio tracing

Внешние ссылки:

Наблюдаемость / Observability

Наблюдаемость позволяет понять систему извне, задавая вопросы о ней, при этом не зная ее внутреннего устройства. Кроме того, она позволяет легко устранять неполадки и решать новые проблемы, то есть «неизвестные неизвестные». Она также поможет вам ответить на вопрос «почему что-то происходит?».

Чтобы задать эти вопросы о вашей системе, приложение должно содержать полный набор инструментов. То есть код приложения должен отправлять сигналы, такие как трассировки, метрики и журналы. Приложение правильно инструментировано, когда разработчикам не нужно добавлять дополнительные инструменты для устранения неполадок, потому что у них есть вся необходимая информация.

Терминология

- Событие журнала (Log event/message) - событие, произошедшее в конкретный момент времени;

- Промежуток (Span record) - запись потока исполнения в системе за период времени. Он также выполняет функции контекста для событий журнала и родителя для под-промежутков;

- Трасса (trace) - полная запись потока исполнения в системе от получения запроса до отправки ответа. Это по сути промежуток-родитель, или корневой промежуток;

- Подписчик (subscriber) - реализует способ сбора данных трассы, например, запись их в стандартный вывод;

- Контекст трассировки (Tracing Context): набор значений, которые будут передаваться между службами

Установка

cargo add tracing

cargo add tracing-subscriber -F json

Использование

Инициализация

Простая инициализация и отслеживание событий:

use tracing::info;

fn main() {

// Установка глобального сборщика по конфигурации

tracing_subscriber::fmt::init();

let number_of_yaks = 3;

// новое событие, вне промежутков

info!(number_of_yaks, "preparing to shave yaks");

}

Ручная инициализация свойств подписчика для форматирования лога:

fn setup_tracing() {

let subscriber = tracing_subscriber::fmt()

.json() // нужно cargo add tracing-subscriber -F json

.with_max_level(tracing::Level::TRACE) // МАХ уровень логирования

.compact() // компактный лог

.with_file(true) // показывать файл-исходник

.with_line_number(true) // показать номера строк кода

.with_thread_ids(true) // показать ID потока с событием

.with_target(false) // не показывать цель (модуль) события

.finish();

tracing::subscriber::set_global_default(subscriber).unwrap();

tracing::info!("Starting up");

tracing::warn!("Are you sure this is a good idea?");

tracing::error!("This is an error!");

}

Трассировка в синхронном режиме

use tracing::{instrument, warn};

#[instrument]

fn sync_tracing() {

warn!("event 1");

sync_tracing_sub();

}

#[instrument]

fn sync_tracing_sub() {

warn!("event 2");

}

fn main() {

setup_tracing();

sync_tracing();

}

Макрос #[instrument] автоматически создаёт промежутки (spans) для функций, а подписчик (subscriber) настроен выводить промежутки в stdout.

Трассировка потоков в асинхронном режиме

use tracing_subscriber::fmt::format::FmtSpan;

#[tracing::instrument] // инструмент следит за временем работы

async fn hello() {

tokio::time::sleep(tokio::time::Duration::from_secs(1)).await;

}

#[tokio::main] // cargo add tokio -F time,macros,rt-multi-thread

async fn main() -> anyhow::Result<()> {

let subscriber = tracing_subscriber::fmt()

.json()

.compact()

.with_file(true)

.with_line_number(true)

.with_thread_ids(true)

.with_target(false)

.with_span_events(FmtSpan::ENTER | FmtSpan::CLOSE) // вход и выход

.finish(); // потока отслеживать

tracing::subscriber::set_global_default(subscriber).unwrap();

hello().await;

Ok(())

}

В итоге получаем лог работы потока с временем задержки:

2024-12-24T14:30:17.378906Z INFO ThreadId(01) hello: src/main.rs:3: {"message":"enter"} {}

2024-12-24T14:30:18.383596Z INFO ThreadId(01) hello: src/main.rs:3: {"message":"enter"} {}

2024-12-24T14:30:18.383653Z INFO ThreadId(01) hello: src/main.rs:3: {"message":"enter"} {}

2024-12-24T14:30:18.383675Z INFO ThreadId(01) hello: src/main.rs:3: {"message":"close","time.busy":"179µs","time.idle":"1.00s"} {}

Запись журнала в хранилище

Внешние ссылки:

Для записи журнала применяется отдельный модуль tracing-appender:

cargo add tracing-appender

У него много функций не только записи в облачные службы типа Datadog, но и создание журнала с дозаписью (минутной, часовой, дневной), а также запись как неблокирующее действие во время многопоточного исполнения.

Пример инициализации неблокирующей записи журнала в файл (лучше всего как JSON), одновременно вывод на экран и организация часового журнала с дозаписью (rolling):

use tracing::{instrument, warn};

// тянем std::io::Write признак в режиме неблокирования

use tracing_subscriber::fmt::writer::MakeWriterExt;

fn setup_tracing() {

// инициализация файла с дозаписью

let logfile = tracing_appender::rolling::hourly("/some/directory", "app-log");

// уровень записи при логировании = INFO

let stdout = std::io::stdout.with_max_level(tracing::Level::INFO);

let subscriber = tracing_subscriber::fmt()

.with_max_level(tracing::Level::TRACE)

.json()

.compact()

.with_file(true)

.with_line_number(true)

.with_thread_ids(true)

.with_target(false)

.with_writer(stdout.and(logfile)) // обязательно указать запись тут

.finish(); // в файл и в stdout консоль

tracing::subscriber::set_global_default(subscriber).unwrap();

}

#[instrument]

fn sync_tracing() {

warn!("event 1");

sync_tracing_sub();

}

#[instrument]

fn sync_tracing_sub() {

warn!("event 2");

}

fn main() {

setup_tracing();

sync_tracing();

}

Инициализация единого трассировщика на проекте

В составе Workspace трассировщик следует инициализировать единожды и далее использовать во всём проекте.

Для этого на верхнем уровне Workspace в Cargo.toml вписываем зависимость с применением по всему Workspace:

[workspace]

members = [ "authentication", "common-log","hello_world", "login"]

[dependencies]

tracing.workspace = true

tracing-appender.workspace = true

tracing-subscriber.workspace = true

[workspace.dependencies]

tracing = "0.1.41"

tracing-appender = "0.2.3"

tracing-subscriber = { version = "0.3.19", features = ["json"] }

Далее, создаём lib crate в Workspace (например, common-logging), у которого в Cargo.toml вписываем:

[dependencies]

tracing = { workspace = true }

tracing-appender = { workspace = true }

tracing-subscriber = { workspace = true }

В файле lib.rs инициализируем логгер:

use tracing_subscriber::fmt::writer::MakeWriterExt;

pub fn setup_tracing() {

let logfile = tracing_appender::rolling::hourly("./log", "auth");

let stdout = std::io::stdout.with_max_level(tracing::Level::INFO);

let subscriber = tracing_subscriber::fmt()

.json()

.with_max_level(tracing::Level::TRACE)

.compact()

.with_file(true)

.with_line_number(true)

.with_thread_ids(true)

.with_target(false)

.with_writer(stdout.and(logfile))

.finish();

tracing::subscriber::set_global_default(subscriber).expect("setting default subscriber failed");

// Проверка разных сообщений логгера:

//tracing::info!("INFO TEXT");

//tracing::warn!("WARNING TEXT");

//tracing::error!("ERROR TEXT");

//tracing::debug!("DEBUG TEXT");

}

#[cfg(test)]

mod tests {

//use super::*;

}

Использование в других крейтах

В библиотеках (Cargo.toml):

[dependencies]

common-logging = { path = "../common-logging" }

tracing = { workspace = true }

tracing-appender = { workspace = true }

tracing-subscriber = { workspace = true }

В библиотеках (lib.rs):

use tracing::{debug, error, info, warn};

pub fn greet_user(name: &str) -> String {

info!("Library _greet_user_ function called"); // вызов логгера

format!("Hello {name}")

}

В бинарном крейте (Cargo.toml):

[dependencies]

common-log = { path = "../common-log" }

tracing = { workspace = true }

tracing-appender = { workspace = true }

tracing-subscriber = { workspace = true }

В бинарном крейте (main.rs):

use common_log::setup_tracing;

use tracing::{debug, error, info, warn};

fn main() {

setup_tracing(); // инициализация логгера из библиотеки common-log

info!("Logger initialized. App started."); // вызов логгера

}

Лог будет сохранён в папке /log/ в бинарном крейте, так как из него делается вызов инициализации.

Использование в тестах

#[cfg(test)]

mod tests {

use super::*;

use common_logging::setup_tracking;

#[test]

fn test_something() {

init_test_logger();

// ваш тест

}

}

Настройка через переменные окружения

# Установка уровня логирования

RUST_LOG=debug cargo run

RUST_LOG=my_library=debug,info cargo run

# Для конкретного крейта

RUST_LOG=my_library=debug cargo run

Binary encoding

Link:

Перевод и работа с двоичными числами

Работа с двоичными числами как со строками

Макрос format! имеет возможность конвертации {:b} числа в двоичное представление при выводе:

fn count_bits(n: i64) -> u32 {

format!("{:b}", n).matches('1').count() as u32

} // посчитать количество '1' битов в числе слева-направо

fn main() {

println!("1234 => {}", count_bits(1234));

} // 1234 => 5

Спец-функции

Можно посчитать количество ‘1’ битов в числе с помощью функции count_ones():

fn count_bits2(n: i64) -> u32 {

n.count_ones()

} // 1234 => 5

Bitwise Operator

Конвертация через побитовый сдвиг числа:

fn bitwise_binary(mut num: u32) -> String {

let mut result = String::new();

let mut started = false;

for i in (0..32).rev() {

let bit = (num >> i) & 1; // побитовый сдвиг

if bit == 1 {

started = true; }

if started {

result.push_str(&bit.to_string()); } }

if result.is_empty() { result.push('0'); } result }

fn main() {

println!("Binary (45): {}", bitwise_binary(45));

} // Binary (45): 101101

Через итераторы

fn iterator_method(mut num: u32) -> String {

if num == 0 {

return "0".to_string();

}

let mut bits = vec![];

while num > 0 {

bits.push((num % 2).to_string());

num /= 2;

}

bits.iter().rev().cloned().collect()

}

fn main() {

println!("Binary (9): {}", iterator_method(9));

} // Binary (9): 1001

External links:

rustup component add rustfmt

rustup component add rust-src

git clone https://github.com/AstroNvim/AstroNvim ~/.config/nvim

nvim +PackerSync

# After install use commands:

:LspInstall rust -> rust-analyzer

:TSInstall rust

- Neovide GUI upgrade on Astro Vim

git clone https://github.com/neovide/neovide

cd neovide

cargo build --release

cargo install evcxr_repl

cargo install irust

VSCode Extensions for Rust

- CodeLLDB

- Dependi (бывш crates) - сообщает, если пакеты устарели

VSCode Settings

(For CodeLLDB) Allow breakpoints everywhere: "debug.allowBreakpointsEverywhere": true

cargo check: поменять check на clippy: "rust-analyzer.check.command": "clippy"

Rust Prelude

Rust has a Prelude - a set of libraries included in every project.

See current libs included in Prelude

std::io::stdin library is used to get user input from standard input stream. Not included in Prelude:

use std:io

let mut guess = String::new();

io::stdin().read_line(&mut guess).expect("Failed to load");

.expect handles Err variant of read_line function, crashing the program with the defined error message.

Subsections of Build Tools

Bacon

Links:

Bacon

Bacon - CLI-утилита запуска команд сборки или тестов по триггеру.

Установка

cargo install --locked bacon

bacon test # run from project folder

Настройка

Запуск команды инициализации:

Приводит к появлению в папке проекта файла bacon.toml с разными вариантами команд, и можно дописать свою секцию, например:

[jobs.check-examples]

command = ["cargo", "run", "--example", "iterators"]

watch = ["examples"]

need_stdout = true

command - команда и параметры

watch - отслеживаемая папка

need_stdout - stdout вывод кода показывать к терминале

Далее запуск секции:

Интерактивный перезапуск компиляции

This will compile+build the code in examples folder, file “variables.rs”. Very convenient to try test different stuff. For live development do:

bacon run -- -q # сборка и запуск текущего проект

bacon run -- -q --example <файл> # сборка и запуск файла в папке examples

bacon test # запуск unit-тестов (например, определённых для lib.rs)

-q - убрать вывод деталей компиляции

(deprecated) Cargo Watch - интерактивный перезапуск компиляции

This will compile+build the code in examples folder, file “variables.rs”. Very convenient to try test different stuff. For live development do:

cargo watch -q -c -x 'run -q --example variables'

-x - rerun upon code change

-c - clear terminal each time

-q - quiet mode

❗Проект cargo watch заморожен, более не развивается.

Cargo

Use Cargo for managing projects.

cargo new test_project // create project with binary file src/main.rs

// OR

cargo new test_project --lib // create project with library file src/lib.rs

cd test_project

Source code is in src folder.

cargo build # build project for debug, do not run

cargo run # build & run project

cargo check # fast compiling

cargo build --release # slow build with optimizations for speed of release version

Documentation of methods & traits used in code can be compiled an opened in browser with Cargo command:

Cargo Examples

Create “examples” folder beside the “src” folder. Create a file named, for example, “variables.rs” and place some test code in the folder. Then in the project root folder run:

cargo run --example variables

Panic Response

В ответ на панику, по умолчанию программа разматывает стек (unwinding) - проходит по стеку и вычищает данные всех функций. Для уменьшения размера можно просто отключать программу без очистки - abort. Для этого в файле Cargo.toml надо добавить в разделы [profile]:

[profile.release]

panic = 'abort'

Important Cargo libs

Секция подробностей работы разных библиотек постепенно пополняется.

- Tokio - async runtime

- Eyre & color-eyre - type signatures, error report handling

- Tracing - collect diagnostic info

- Reqwest - HTTP requests library, async

- Rayon - data parallelism library, without data races

- Clap - commandline passing library

- SQLX - compile-checked SQL, async

- Chrono - time/date library

- EGUI - web-gui @60FPS, runs in Webassembly

- Yew.rs - web-library like React.js

Cargo Workspaces

Links:

Проект с Cargo Workspaces

Объединение кода в 1 проект. В Cargo.toml нужно объявить его структуру:

[package]

name = "ardan_workspace"

version = "0.1.0"

edition = "2021"

[dependencies]

[workspace]

members = [

"session1/hello_world",

"session1/variables",

]

После этого можно добавлять подпрограммы в members, через cargo new <подрограмма>.

Создание и подключение библиотеки в Workspace

Создание библиотеки вместо бинарника - `cargo new –lib examplelib

Прописать в файле cargo.toml у бинарной программы в workspace зависимость:

<..>

[dependencies]

examplelib = { path = "../examplelib"}

Далее, в код бинарной программы включить функции из библиотеки:

use examplelib::function01; // фукнкция должна быть публичной (pub fn)

Единая инициализация и сборка библиотек зависимостей в Workspace

Создаём проект типа workspace и прописываем в его файле Cargo.toml верхнего уровня все библиотеки с версиями (в примере anyhow) в спец разделе [workspace.dependencies]:

[dependencies]

anyhow.workspace = true

[workspace]

members = ["greeter"]

[workspace.dependencies]

anyhow = "1.0.99"

При этом в отдельном разделе [dependencies] указываем, что библиотеки будут распространяться на весь проект. Далее, создаём модуль внутри workspace (в примере = greeter) и в его файле Cargo.toml прописываем, что библиотека берётся из зависимостей workspace:

[dependencies]

anyhow = { workspace = true }

Можно добавлять features к библиотеке из workspace на этапе описания вложенных модулей:

[dependencies] regex = { workspace = true, features = ["unicode"] }

Проверка зависимостей

Можно построить дерево зависимостей и проверить правильность написания cargo.toml файла:

Clippy

Настройка

Clippy идёт в составе стандартной поставки Rustup.

Пример конфигурации:

cargo clippy --fix -- \

-W clippy::pedantic \

-W clippy::nursery \

-W clippy::unwrap_used \

-W clippy::expect_used

VSCode Settings

cargo check: поменять check на clippy: "rust-analyzer.check.command": "clippy"

Книга

У Clippy есть своя книга в формате Markdown:

cargo install mdbook

# Run from top level of your rust-clippy directory:

mdbook serve book --open

# Goto http://localhost:3000 to see the book

Исключения

Allow Unused / dead code

Убрать warnings на тему неиспользуемых функций или переменных - самой первой строчкой кода включить директиву:

#![allow(unused)]

fn main() {}

Либо у конкретных функций указывать:

#![allow(dead_code)]

fn some_func() { todo!() }

Panamax

Cargo OFFLINE

Для создания локального сервера можно скачать все пакеты Cargo с помощью проекта Panamax.

cargo install --locked panamax

panamax init ~/test/my-mirror

Нужно зайти в папку my-mirror, проверить настройки в файле mirror.toml. И далее запустить синхронизацию:

panamax sync ~/test/my-mirror

Далее, можно публиковать зеркало по веб через встроенный сервер (по порту 8080):

panamax serve ~/test/my-mirror

На индекс странице сервера будет справка по подключению Rust клиентов к зеркалу. В частности, посредством создания файла настроек ~/.cargo/config :

[source.my-mirror]

registry = "http://panamax.local/crates.io-index"

[source.crates-io]

replace-with = "my-mirror"

CLI Arguments

ARGS

Аргументы командной строки можно захватить с помощью методов args()+collect() библиотеки env. Нужно поместить их в строковый вектор.

use std::env;

fn main() {

let args: Vec<String> = env::args().collect();

for arg in args.iter() {

println!("{}", arg);

} }

Первым параметров всегда идёт имя самой программы.

Tip

Продвинутую обработку аргументов CLI удобно делать с помощью библиотеки Clap

Closures

Внешняя ссылка: https://habr.com/ru/articles/588917/

Статьи в разделе:

Closure

Замыкания - анонимные функции. Их можно присвоить переменным и вызывать. Это также функция, которая ссылается на свободные переменные в своей области видимости. Базовое использование:

let add_one = |x: i32| -> i32 { x + 1 };

println!("Add one to 5 = {}", add_one(5)); // Add one to 5 = 6

let add_two = |x| x + 2;

println!("Add two to 5 = {}", add_two(5)); // Add two to 5 = 7

let add = |a, b| a + b;

println!("Sum of 5 and 6 = {}", add(5, 6)); // Sum of 5 and 6 = 11

let just_number = || 42;

println!("Answer to all: {}", just_number()); // Answer to all: 42

В отличие от функций, замыкания могут использовать переменные вне своего блока:

(0..3).for_each(|x| {println!("map i = {}", x * 2);});

let factor = 2;

let multiplier = |x| x * factor;

println!("{}", multiplier(5)); // 10

println!("Factor: {factor}"); // factor ещё доступен тут

move

Ключ move перемещает переменную в замыкание:

let greet = move || {

println!("Hello, {}!", name);

};

greet();

// println!("{name}"); даст ошибку

Это нужно для того, чтобы замыкание получило владение данным и пережило scope, в котором оно было объявлено.

Работа с итераторами

.map(<closure>) передаёт владение элементами итератора замыканию, чтобы их можно было трансформировать в другие элементы, которые далее возвращает замыкание.

.filter(<closure>) возвращает оригинальные элементы, когда предикат замыкания возвращает true. Таким образом, отдавать владение элементами замыканию нельзя, и нужно передавать по ссылке.

let x2: Vec<i32> = nums.iter().map(|x| x * 2).collect();

println!("x2 = {x2:?}"); // x2 = [2, 4, 6, 8, 10]

let evens: Vec<&i32> = nums.iter().filter(|&x| x % 2 == 0).collect();

println!("Evens = {evens:?}"); // Evens = [2, 4]

let even_sum: i32 = (0..=10).filter(|n| *n % 2 == 0).sum()

2 в 1 = filter_map()

Можно вернуть элементы, когда предикат значения true, и сразу же их трансформировать. На вход он принимает замыкание, возвращающее Option<T>:

- Если на выходе

Some(value), значение включается в результат;

- Если замыкание возвращает

None, элемент исключается фильтром.

let numbers = vec!["1", "2", "abc", "4"];

// Раздельно: filter() и потом map()

let result: Vec<i32> = numbers

.iter()

.filter(|s| s.parse::<i32>().is_ok()) // фильтровать цифры

.map(|s| s.parse::<i32>().unwrap()) // Перевести их в int

.collect();

// Result: [1, 2, 4]

// Вместе: filter_map()

let result: Vec<i32> = numbers

.iter()

.filter_map(|s| s.parse::<i32>().ok()) // фильтр и перевод в 1 шаг

.collect();

// Result: [1, 2, 4]

Вложенные замыкания map()

let a = (0..=3).map(|x| x * 2).map(|y| y - 1);

// первая итерация map(): 2, 4, 6

// вторая итерация map(): 1, 3, 5

for i in a {

println!("{i}");

}

All

Замыкание all возвращает True, если все элементы в замыкании соответствуют условию.

let a: Vec<i32> = vec![1, 2, 3, 4];

print!("{}\n", a.into_iter().all(|x| x > 1)); // false

Для пустого вектора замыкание all вернёт True:

let a: Vec<i32> = vec![];

print!("{}\n", a.into_iter().all(|x| x > 1)); // true

Цикл через замыкание vs for

use std::collections::HashMap;

pub fn main() {

let num_vec = vec![1, 2, 1, 3, 5, 2, 1, 4, 6];

let mut number_count: HashMap<i32, i32> = HashMap::new();

for key in num_vec {

*number_count.entry(key).or_default() += 1;

}

/* for (k, v) in number_count {

print!("{} -> {}; ", k, v);

} */

number_count.iter().for_each(|(k, v)| {

print!("{} -> {}; ", k, v);

}); //цикл через замыкание итератора

}

Subsections of Closures

Fold

fold используется для превращения множества в 1 значение.

Базовый синтаксис

fn fold<B, F>(self, init: B, f: F) -> B

where

F: FnMut(B, Self::Item) -> B,

init: исходное значение счётчика;f: замыкание, которое тоже принимает 2 аргумента: счётчик и объект. Замыкание возвращает счётчик.

Как работает

fold() преобразовывает каждый элемент по цепочке :

- Начинает со значения

init в счётчике;

- Для каждого элемента применяет замыкание

f(accumulator, element);

- Возвращает финальное значение счётчика после обработки всех элементов.

Наглядно по шагам:

fold(init, |acc, x| f(acc, x))

// Шаг 1: acc = init

// Шаг 2: acc = f(init, item1)

// Шаг 3: acc = f(acc, item2)

// Шаг 4: acc = f(acc, item3)

// ...

// Возврат финального acc

Сумма чисел:

let numbers = vec![1, 2, 3, 4, 5];

let sum = numbers.iter().fold(0, |acc, &x| acc + x);

println!("Sum: {}", sum); // 15

// По шагам:

// acc = 0

// acc = 0 + 1 = 1

// acc = 1 + 2 = 3

// acc = 3 + 3 = 6

// acc = 6 + 4 = 10

// acc = 10 + 5 = 15

// код выше можно заменить на sum()

Произведение чисел:

let numbers = vec![1, 2, 3, 4, 5];

let product = numbers.iter().fold(1, |acc, &x| acc * x);

println!("Product: {}", product); // 120

// код выше можно заменить на product()

Нахождение максимального значения

let numbers = vec![3, 1, 4, 1, 5, 9, 2];

let max = numbers.iter().fold(i32::MIN, |acc, &x| acc.max(x));

println!("Max: {}", max); // 9

Соединение (конкатенация) строк

Счётчик у fold необязательно числовой, можно использовать, например, String:

fn hello_world_concat() {

let words = vec!["hello", "world", "rust"];

let sentence = words.iter().fold(String::new(), |acc, &word| {

if acc.is_empty() {

word.to_string()

} else {

acc + " " + word

}});

println!("Sentence: '{}'", sentence); // "hello world rust"

}

fn giant_grunts(initial: char) -> String {

["Bee", "Fee", "Gee", "Fi", "Hi", "Fo", "Mo", "Fum", "Tum"].iter().fold(

String::new(),

|acc, grunt| if grunt.starts_with(initial) { acc + grunt } else { acc },

)}

fn main() {

let song = giant_grunts('F');

println!("{song:?}"); // "FeeFiFoFum"

}

Разделение на чётные и нечётные

let numbers = vec![1, 2, 3, 4, 5];

let result = numbers.iter().fold(

(Vec::new(), Vec::new()), // (evens, odds)

|(mut evens, mut odds), &x| {

if x % 2 == 0 {

evens.push(x);

} else {

odds.push(x);

}

(evens, odds)

}

);

println!("Evens: {:?}, Odds: {:?}", result.0, result.1);

// Evens: [2, 4], Odds: [1, 3, 5]

Получение частоты символов в тексте:

Создаёт HashMap. Заменяет итератор counts() из библиотеки itertools:

use std::collections::HashMap;

pub fn first_non_repeating(s: &str) -> Option<HashMap<char, i32>> {

let char_frequency = s.chars().fold(HashMap::new(), |mut acc, c| {

*acc.entry(c).or_insert(0) += 1;

acc

});

Some(char_frequency)

}

fn main() {

println!("Letter frequency: {:?}", first_non_repeating("stress"));

} // Letter frequency: Some({'e': 1, 'r': 1, 's': 3, 't': 1})

arr.chars(): Creates an iterator over references to the array elements (chars).fold(HashMap::new(), ...): Reduces the iterator to a single value (HashMap)

HashMap::new(): Initial empty HashMap (the starting accumulator)|mut acc, x|: Closure with parameters:

mut acc: Mutable accumulator (the HashMap being built)c: Current element from the iterator (reference to a string like &"abc")

По шагам:

acc.entry(x): Calls entry() on the HashMap with key c

- This returns an

Entry enum (Occupied or Vacant) for the key c

.or_insert(0): Entry API method

- If key

c doesn’t exist in the map: inserts value 0 and returns mutable reference to it

- If key

c already exists: returns mutable reference to the existing value

*... += 1: Dereferences and increments

- The

or_insert(0) returns &mut i32 (mutable reference to integer)

* dereferences to get the actual integer value+= 1 increments the count by 1

Реализация других методов

Реализация map()

let numbers = vec![1, 2, 3, 4, 5];

let doubled: Vec<i32> = numbers.iter().fold(Vec::new(), |mut acc, &x| {

acc.push(x * 2);

acc });

println!("Doubled: {:?}", doubled); // [2, 4, 6, 8, 10]

Реализация filter()

let numbers = vec![1, 2, 3, 4, 5, 6];

let evens: Vec<i32> = numbers.iter().fold(Vec::new(), |mut acc, &x| {

if x % 2 == 0 {

acc.push(x); }

acc });

println!("Evens: {:?}", evens); // [2, 4, 6]

Вариация try_fold()

От fold() отличается тем, что прерывает выполнение и возвращает Result(Err):

let strings = ["1", "2", "3", "4", "5"];

// перевести строки в числа и суммировать их

let sum: Result<i32, _> = strings

.iter()

.try_fold(0, |acc, &s| match s.parse::<i32>() {

Ok(num) => Ok(acc + num),

Err(e) => Err(e),

});

match sum {

Ok(total) => println!("Total: {}", total), // 15

Err(e) => println!("Parse error: {}", e), }

Collections

Сравнение коллекций

| Коллекция |

Доступ по индексу |

Вставка |

Поиск |

Память |

Vec |

O(1) |

O(1) аморт.* |

O(n) |

Непрерывная |

String |

O(1) (по байтам) |

O(1) аморт.* |

O(n) |

Непрерывная |

HashMap |

— |

O(1) в среднем |

O(1) в среднем |

Разбросанная |

HashSet |

— |

O(1) в среднем |

O(1) в среднем |

Разбросанная |

|

|

|

|

|

*Амортизированная O(1) — в среднем быстрая, но может быть O(n) при перевыделении памяти.

Vec хорош для последовательного доступа, но поиск медленный;HashMap и HashSet быстры для поиска, но требуют больше памяти из-за хэш-таблицы.

Subsections of Collections

HashMap & BTreeMap

Hashmap<K, V, S = RandomState>

Это изменяемая структура словарь (“dictionary” в Python), которая хранит пары “ключ->значение”. В Rust Prelude она не входит, макроса создания не имеет. Поэтому нужно указывать библиотеку явно и явно создавать структуру.

use std::collections::HashMap;

fn main() {

let mut scores = HashMap::new();

scores.insert(String::from("Alpha"),1);

scores.insert(String::from("Beta"),2);

scores.insert(String::from("Gamma"),3);

}

Все ключи Hashmap должны быть уникальны и одного типа, все значения должны быть одного типа.

Warning

Значения с кучи типа String перемещаются (move) в Hashmap, который становится их владельцем.

Взятие значения по ключу из Hashmap с помощью get нужно сопровождать проверкой - есть ли в памяти запрашиваемые ключ и значение:

let name = String::from("Gamma");

if let Some(letter_num) = scores.get(&name) {

println!("{}",letter_num);

} else { println!("Value not in HashMap!"); }

Итерация по Hashmap похожа на итерацию по вектору:

for (key, value) in &scores {

println!("{key} -> {value}"); }

Обновление Hashmap

Есть ряд стратегий обновления значений в Hashmap:

scores.insert(String::from("Gamma"),3); // вставка дважды значений по одному

scores.insert(String::from("Gamma"),6); // ключу сохранит последнее значение

- Записывать значение, если у ключа его нет:

scores.entry(String::from("Delta")).or_insert(4); // entry проверяет наличие

// значения, or_insert возвращает mut ссылку на него, либо записывает новое

// значение и возвращает mut ссылку на это значение.

- Записывать значение, если ключа нет. Если же у ключа есть значение, модифицировать его:

use std::collections::HashMap;

let mut map: HashMap<&str, u32> = HashMap::new();

map.entry("poneyland") // первое добавление

.and_modify(|e| { *e += 1 })

.or_insert(42); // добавит ключ "poneyland: 42"

assert_eq!(map["poneyland"], 42);

map.entry("poneyland") // второе добавление найдёт ключ со значением

.and_modify(|e| { *e += 1 }) // и модифицирует его

.or_insert(42);

assert_eq!(map["poneyland"], 43);

- Записывать значение, если ключа нет, в виде результата функции. Эта функция получает ссылку на значение ключа key, который передаётся в .entry(key):

use std::collections::HashMap;

let mut map: HashMap<&str, usize> = HashMap::new();

map

.entry("poneyland")

.or_insert_with_key(|key| key.chars().count());

assert_eq!(map["poneyland"], 9);

- Поднимать старое значение ключа, проверять его перед перезаписью:

let text = "hello world wonderful world";

let mut map = HashMap::new();

for word in text.split_whitespace() {

let count = map.entry(word).or_insert(0);

*count += 1;

}

println!("{:?}",map); // {"wonderful": 1, "hello": 1, "world": 2}

Инициализация HashMap со значениями по-умолчанию

Поведение аналогично типу defaultdict в Python. Заполнять ключами HashMap:

- в случае отсутствия ключа, создавать его со значением по-умолчанию (0);

- в случае присутствия ключа, добавлять к значению +1.

Аналогичный подход реализуется с fold(), а также с помощью itertools::counts() :

use std::collections::HashMap;

pub fn main() {

let num_vec = vec![1, 2, 1, 3, 5, 2, 1, 4, 6];

let mut number_count: HashMap<i32, i32> = HashMap::new();

for key in num_vec {

*number_count.entry(key).or_default() += 1;

}

for (k, v) in number_count {

print!("{} -> {}; ", k, v);

}

}

// 4 -> 1; 1 -> 3; 2 -> 2; 6 -> 1; 5 -> 1; 3 -> 1;

Метод entry позволяет избежать проверки contains_key вручную.

Более простой аналог с for_each():

let mut number_count = HashMap::new();

num_vec.iter().for_each(|s| {

*number_count.entry(s).or_insert(0) += 1;

});

Удаление элемента

use std::collections::HashMap;

let mut map: HashMap<&str, i32> = HashMap::from([

("a", 1),

("b", 2),

("c", 3),

]);

map.remove("b"); // удаляет по ключу "b"

println!("{:?}", map); // {"a": 1, "c": 3}

Альтернатива: Если не нужно сдвигать элементы, можно использовать .swap_remove(index) (быстрее, O(1), но меняет порядок):

let mut numbers = vec![1, 2, 3, 4];

numbers.swap_remove(1); // заменяет на последний элемент и удаляет его

println!("{:?}", numbers); // [1, 4, 3]

Сортировка HashMap

Если нужно отсортировать по значениям придётся:

- Преобразовать

HashMap в вектор пар (ключ, значение);

- Отсортировать его;

- Собрать обратно (если нужно).

use std::collections::HashMap;

let mut hmap: HashMap<&str, i32> = HashMap::from([

("b", 3),("a", 1),("c", 2),]);

let mut hsorted = hmap.into_iter().collect::<Vec<(&str, i32)>>();

hsorted.sort_by(|a, b| a.1.cmp(&b.1)); // сортировка по значению

println!("{:?}", hsorted); // [("a", 1), ("c", 2), ("b", 3)]

BTreeMap<K, V, A = Global>

Упорядоченная по ключам K структура данных на основе B-дерева.

Ключевые отличия от HashMap:

| Свойство |

HashMap |

BTreeMap |

| Внутренняя структура |

Хэш таблица |

Дерево поиска |

| Упорядоченность |

Не гарантированная |

Ключи всегда упорядочены |

| Скорость |

O(1) |

O(log n) |

| Требования |

Hash + Eq |

Ord |

| Потребление памяти |

Выше |

Ниже |

Применение

Когда нужно сразу сортировать данные:

let mut scores = BTreeMap::new();

scores.insert("Charlie", 85);

scores.insert("Alice", 92);

scores.insert("Bob", 78);

// Итерация сразу в отсортированном порядке по ключам

for (name, score) in &scores {

println!("{}: {}", name, score); // Alice, Bob, Charlie

}

// Получить 1ый и последний элементы

println!("{:?}", scores.first_key_value()); // ("Alice", 92)

println!("{:?}", scores.last_key_value()); // ("Charlie", 85)

Работа с диапазонами значений:

// Диапазоны заданы кортежами (нижняя_граница, верхняя_граница)

let mut price_ranges = BTreeMap::new();

price_ranges.insert((0, 10), "Budget");

price_ranges.insert((11, 50), "Standard");

price_ranges.insert((51, 100), "Premium");

price_ranges.insert((101, 1000), "Luxury");

let query_price = 42;

// Поиск по диапазонам (линейный в данном случае)

for ((low, high), category) in &price_ranges {

if query_price >= *low && query_price <= *high {

println!(

"Price ${} is in category: {} (range: {}-{})",

query_price, category, low, high

);

break;

} }

Порядок при сериализации в JSON:

use serde_json

let mut config = BTreeMap::new();

config.insert("zebra", "animal");

config.insert("apple", "fruit");

config.insert("banana", "fruit");

// сериализация в JSON с порядком элементов

let json = serde_json::to_string_pretty(&config).unwrap();

println!("{}", json); // ключи будут в порядке: apple, banana, zebra

Сравнение HashMap vs BTreeMap по скорости

use std::collections::{BTreeMap, HashMap};

use std::time::Instant;

fn main() {

let n = 100_000;

// HashMap insertion

let start = Instant::now();

let mut hash_map = HashMap::new();

for i in 0..n {

hash_map.insert(i, i * 2);

}

println!("HashMap insert: {:?}", start.elapsed());

// BTreeMap insertion

let start = Instant::now();

let mut btree_map = BTreeMap::new();

for i in 0..n {

btree_map.insert(i, i * 2);

}

println!("BTreeMap insert: {:?}", start.elapsed());

}

// HashMap insert: 50.855881ms

// BTreeMap insert: 102.619694ms

Для небольших коллекций (< 1000 элементов) или когда требуется отсортированный порядок, BTreeMap часто предпочтительнее. Для больших коллекций, где нужна максимальная скорость, а порядок не имеет значения, HashMap обычно лучше.

HashSet & BTreeSet

Оба типа представляют множества для хранения уникальных элементов.

Отличия HashSet и BTreeSet

| Множество |

HashSet |

BTreeSet |

| Сортировка |

Случайный порядок |

Да |

| Сложность алгоритма |

O(1) в среднем |

O(log n) |

| Потребление памяти |

Выше (hash-таблица) |

Ниже |

| Запросы диапазонов значений |

Нет |

Да |

| Типажи |

T: Hash + Eq |

T: Ord |

Работа с HashSet

use std::collections::HashSet;

fn main() {

// Создание

let mut colors = HashSet::new();

// Добавление элеметов

colors.insert("red");

colors.insert("green");

colors.insert("blue");

colors.insert("red"); // дубликат - не будет добавлен!

println!("HashSet: {:?}", colors); // порядок произвольный

// Проверка существования элемента

if colors.contains("green") {

println!("Contains green!");

}

// Итерация (порядок не гарантирован)

for color in &colors {

println!("Color: {}", color);

}

// Удаление элемента

colors.remove("blue");

// Объединение двух HashSet

let mut warm_colors = HashSet::new();

warm_colors.insert("red");

warm_colors.insert("yellow");

warm_colors.insert("orange");

let all_colors: HashSet<_> = colors.union(&warm_colors).collect();

println!("All colors: {:?}", all_colors);

}

Работа с BTreeSet

use std::collections::BTreeSet;

fn main() {

// Создание BTreeSet

let mut numbers = BTreeSet::new();

// Вставка элементов (авто-сортировка!)

numbers.insert(5);

numbers.insert(2);

numbers.insert(8);

numbers.insert(1);

numbers.insert(5); // дубликат - не будет добавлен!

println!("BTreeSet: {:?}", numbers); // сортировка всегда: {1, 2, 5, 8}

// Проверка существования элемента

if numbers.contains(&2) {

println!("Contains 2!");

}

// Итерация по порядку

for num in &numbers {

println!("Number: {}", num); // 1, 2, 5, 8

}

// Получить первый и последний элементы

if let Some(first) = numbers.first() {

println!("First element: {}", first); // 1

}

if let Some(last) = numbers.last() {

println!("Last element: {}", last); // 8

}

// Запрос диапазона значений

let range: Vec<_> = numbers.range(2..=5).collect();

println!("Numbers between 2 and 5: {:?}", range); // [2, 5]

// Удаление элемента

numbers.remove(&5);

}

HashSet -> Vector

Простой способ:

use std::collections::HashSet;

let set: HashSet<char> = ['a', 'b', 'c', 'd'].into_iter().collect();

// Перевод в Vec<char> - расстановка элементов произвольная

let vec: Vec<char> = set.into_iter().collect();

println!("Vec: {:?}", vec); // Example: ['c', 'a', 'd', 'b']

С сохранением исходного HashSet:

let vec: Vec<char> = set.iter().cloned().collect();

Vectors

Vectors

Вектор - множество данных одного типа, количество которых можно изменять: добавлять и удалять элементы. Нужен, когда:

- требуется собрать набор элементов для обработки в других местах;

- нужно выставить элементы в определённом порядке, с добавлением новых элементов в конец;

- нужно реализовать стэк;

- нужен массив изменяемой величины и расположенный в куче.

Методы

// Задание пустого вектора:

// let mut a test_vector: Vec<i32> = Vec::new();

// Задание вектора со значениями через макрос:

let mut test_vector = vec![1, 2, 3, 4];

test_vector.push(42); // добавить число 42 в конец mut вектора

let Some(last) = test_vector.pop(); // удаляет и возвращает последний элемент (возвращает Option<T>)

test_vector.remove(0); // удалить первый элемент =1

for i in &mut test_vector { // пройти вектор как итератор для вывода

*i += 1; // изменять значения при их получении требует делать '*' dereference

println!("{i}"); }

println!("Vector length: {}", test_vector.len()); // количество элементов

extend() - расширить вектор с помощью итератора:

let mut test_vector = vec![1, 2, 3, 4];

test_vector.extend([5, 6, 7, 8].iter());

println!("{:?}", test_vector); // [1, 2, 3, 4, 5, 6, 7, 8]

chain() - соединяет 2 итератора вместе, элементы второго после всех элементов первого:

let test_vector = [1, 2, 3, 4];

let test_vector = test_vector

.iter()

.chain([5, 6, 7, 8].iter())

.collect::<Vec<&i32>>();

println!("{:?}", test_vector); // [1, 2, 3, 4, 5, 6, 7, 8]

Получение элемента вектора

Элемент можно получить либо с помощью индекса, либо с помощью безопасного метода get:

let mut test_vector = vec![1,2,3,4,5];

println!("Third element of vector is: {}", &test_vector[2]); // индекс

let third: Option<&i32> = test_vector.get(2); // безопасный метод get

match third {

Some(third) => println!("Third element of vector is: {}", third),

None => println!("There is no third element")

}

Разница в способах в реакции на попытку взять несуществующий элемент за пределами вектора. Взятие через индекс приведёт к панике и остановке программы. Взятие с помощью get сопровождается проверкой и обработкой ошибки.

Удаление элемента

Метод .remove(index):

let mut numbers = vec![1, 2, 3, 4];

numbers.remove(1); // удаляет элемент с индексом 1

println!("{:?}", numbers); // [1, 3, 4]

.remove() сдвигает все последующие элементы, что может быть дорого для больших векторов (O(n));- Возвращает удалённый элемент;

- Требует

mut, так как изменяет вектор;

- Индекс должен быть в пределах длины, иначе паника.

Хранение элементов разных типов в векторе

Rust нужно заранее знать при компиляции, сколько нужно выделять памяти под каждый элемент. Если известны заранее все типы для хранения, то можно использовать промежуточный enum:

#[derive(Debug)]

enum SpreadSheet {

Int(i32),

Float(f64),

Text(String)

}

fn main() {

let row = vec![

SpreadSheet::Int(42),

SpreadSheet::Float(3.14),

SpreadSheet::Text(String::from("red"))

];

for i in row {

println!("{:?}",i);

} }

Vector со строками String

let mut v: Vec<String> = Vec::new();

Пустой вектор с нулевыми строками можно создать через Default размером до 32 элементов (Rust 1.47):

let v: [String; 32] = Default::default();

Вектор большего размера можно создать через контейнер Vec:

let mut v: Vec<String> = vec![String::new(); 100];

Вектор с заданными строками можно инициализировать либо с помощью метода to_string(), либо через определение макроса:

macro_rules! vec_of_strings {

($($x:expr),*) => (vec![$($x.to_string()),*]);

}

fn main()

{

let a = vec_of_strings!["a", "b", "c"];

let b = vec!["a".to_string(), "b".to_string(), "c".to_string()];

assert!(a==b); // True

}

Соединение вектора со строками в строку (Join):

result_vec.join(" "); // указывается разделитель для соединения

// в старых версиях Rust <1.3 применяют метод .connect();

Сортировка

let number_vector = vec!(1,12,3,1,5);

number_vector.sort(); // 1,1,3,5,12

Способы реверс-сортировки

Смена элементов при сравнении, метод .sort_by() принимает замыкание (closure) для пользовательской сортировки:

number_vector.sort_by(|a,b| b.cmp(a));

|a, b| — это замыкание;b.cmp(a) возвращает порядок: Ordering::Less, Equal или Greater. Инверсия (b.cmp(a) вместо a.cmp(b)) даёт убывающий порядок.

Альтернатива: .sort_by_key() для сортировки по вычисляемому ключу:

let mut numbers = vec![3, 1, 4, 1, 5];

numbers.sort_by_key(|&x| -x); // по убыванию через отрицание

println!("{:?}", numbers); // [5, 4, 3, 1, 1]

Сортировка, потом реверс:

number_vector.sort();

number_vector.reverse();

Обёртка Reverse с экземпляром Ord:

use std::cmp::Reverse;

number_vector.sort_by_key(|w| Reverse(*w));

Если вернуть Reverse со ссылкой и без *, это приведёт к проблеме с временем жизни.

Сортировка вектора по ключу

use std::collections::HashSet;

fn main() {

let mut vowels = HashSet::new();

vowels.insert('e');

vowels.insert('a');

vowels.insert('i');

vowels.insert('o');

vowels.insert('u');

// Конвертация в Vec и сортировка

let mut vowel_vec: Vec<char> = vowels.into_iter().collect();

// Свой порядок сортировки: a, e, i, o, u

let vowel_order = |c: &char| match c {

'a' => 0,

'e' => 1,

'i' => 2,

'o' => 3,

'u' => 4,

_ => 5,

};

vowel_vec.sort_by_key(vowel_order);

println!("Sorted vowels: {:?}", vowel_vec); // ['a', 'e', 'i', 'o', 'u']

}

Дедупликация вектора

Удаление одинаковых элементов в векторе, похоже на работу с HashSet.

let s = "aabbccdddeeeeffffeee";

let mut chars: Vec<char> = s.chars().collect();

// Сначала отсортировать, чтобы собрать одинаковые элементы вместе

chars.sort_unstable();

// dedup() удаляет на месте одинаковые СТОЯЩИЕ РЯДОМ в векторе элементы

chars.dedup();

// собрать назад в String:

let unique_s: String = chars.into_iter().collect();

Получение вектора из итератора

let collected_iterator: Vec<i32> = (0..10).collect();

println!("Collected (0..10) into: {:?}", collected_iterator);

// Collected (0..10) into: [0, 1, 2, 3, 4, 5, 6, 7, 8, 9]

Конвертация

Конвертация из массива array в vector:

let number_list = [1,12,3,1,5,2];

let number_vector = number_list.to_vec(); // перевод array[i32] -> vector<i32>

Вариант через итератор:

let a = [10, 20, 30, 40];

let v: Vec<i32> = a.iter().map(|&e| e as i32).collect();

Вектор из байтов vector of bytes в строку String:

use std::str;

fn main() {

let buf = &[0x41u8, 0x41u8, 0x42u8]; // vector of bytes

let s = match str::from_utf8(buf) {

Ok(v) => v,

Err(e) => panic!("Invalid UTF-8 sequence: {}", e),

};

println!("result: {}", s);

}

Constants

Константы

Это глобальные по области действия значения, неизменяемые. При объявлении нужно всегда сразу указывать их тип.

const MAX_LIMIT: u8 = 15; // тип u8 обязательно надо указать

fn main() {

for i in 1..MAX_LIMIT {

println!("{}", i);

} }

Cross-compiling

Проверка системы

Сделать новый проект, добавить в него библиотеку cargo add current_platform. Далее создаём и запускаем код проверки среды компиляции и исполнения:

use current_platform::{COMPILED_ON, CURRENT_PLATFORM};

fn main() {

println!("Run from {}! Compiled on {}.", CURRENT_PLATFORM, COMPILED_ON);

}

- Посмотреть текущую ОС компиляции:

rustc -vV

- Посмотреть список ОС для кросс-компиляции:

rustc --print target-list

Формат списка имеет поля <arch><sub>-<vendor>-<sys>-<env>, например, x86_64-apple-darwin => macOS на чипе Intel.

Настройка кросс-компилятора

Нужно установить cross: cargo install cross установит его по пути $HOME/.cargo/bin

Далее, нужно установить вариант Docker в системе:

- На macOS => Docker Desktop;

- На Linux => Podman

Запуск кода на компиляцию под ОС Windows: cross run --target x86_64-pc-windows-gnu => в папке target/x86_64-pc-windows-gnu/debug получаем EXE-файл с результатом.

❗Компиляция проходит через WINE.

Проверка среды компиляции

Cross поддерживает тестирование других платформ. Добавка проверки:

mod tests {

use current_platform::{COMPILED_ON, CURRENT_PLATFORM};

#[test]

fn test_compiled_on_equals_current_platform() {

assert_eq!(COMPILED_ON, CURRENT_PLATFORM);

} }

Запустить проверку локально: cargo test

Запустить проверку с кросс-компиляцией: cross test --target x86_64-pc-windows-gnu

На Linux/macOS проверка пройдёт, а вот при компиляции под Windows - нет:

`test tests::test_compiled_on_equals_current_platform … FAILED

Добавка платформенно-специфичного кода

Можно вписать код, который запустится только на определённой ОС, например, только на Windows:

use current_platform::{COMPILED_ON, CURRENT_PLATFORM};

#[cfg(target_os="windows")]

fn windows_only() {

println!("This will only print on Windows!");

}

fn main() {

println!("Run from {}! Compiled on {}.", CURRENT_PLATFORM, COMPILED_ON);

#[cfg(target_os="windows")]

{

windows_only();

}

}

Enums

Перечисления

Перечисление — это тип данных, который позволяет определить набор именованных значений (вариантов). Каждый вариант может быть просто именем или содержать дополнительные данные.

Здесь мы определили перечисление Money с двумя вариантами: Rub, и Kop. Эти варианты не содержат дополнительных данных — они просто имена, которые представляют возможные состояния. В терминах Rust такие варианты без данных часто называют “unit-like” (похожими на Unit), но это не совсем то же самое, что массив или указатели.

Unit

“Unit” в Rust — это специальный тип (), который имеет только одно значение, тоже обозначаемое как (). Это что-то вроде “пустого значения”, которое часто используется, когда функция ничего не возвращает. Например:

fn do_nothing() {

// Ничего не возвращаем, implicitly возвращается ()

}

В случае с Money каждый вариант (Rub и Kop) сам по себе не является типом (), но его можно рассматривать как “unit-like”, потому что он не несёт дополнительных данных. Это просто маркер, который говорит: “Я одно из двух состояний”.

Enum в памяти

Внутри памяти Money представлен как небольшое целое число (обычно 1 байт для простых перечислений вроде этого), называемое “дискриминантом”. Этот дискриминант указывает, какой вариант сейчас используется:

Money::Rub → 0Money::Kop → 1

Но это внутренняя реализация. Для программиста это просто разные состояния.

match

Аналог switch в других языках, однако, круче: его проверка не сводится к bool, а также реакция на каждое действие может быть блоком:

fn main() {

let number = 42;

match number {

n if n > 0 => println!("Положительное: {}", x),

n if n < 0 => println!("Отрицательное: {}", y),

_ => println!("Ноль"), } }